最近deepseek,qwq等开源大模型性能突飞猛进,但是网上各种web服务不太稳定,遂尝试在图形工作站上本地化部署。

windows操作系统部署ollama

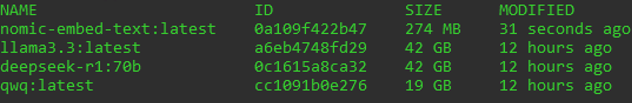

网上很容易找到,最简单的本地化部署方法是ollama。而 ollama 中刚好也提供了 deepseek-r1, qwq 等模型的下载。默认70b主要是q4km量化模型,大概也就40GB出头。而工作站上配了两块A6000,加起来显存快100GB,所以应该是能够比较流畅运行 70b 这个大小的模型的。

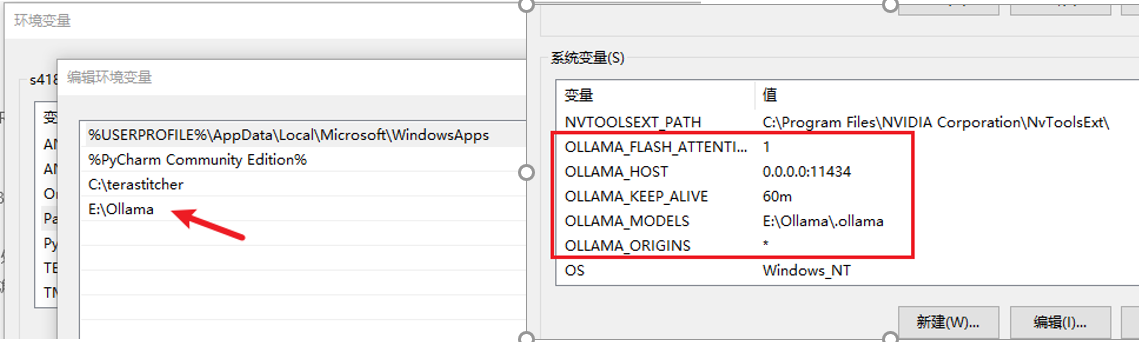

安装完 ollama 之后,要修改一些配置,简单记录一下。主要就是各种环境变量。

一个是用户环境变量PATH中,我把 ollama 安装到容量比较大的 E 盘了。另外就是系统环境变量。

- OLLAMA_HOST=0.0.0.0:11434,改成这样就可以让别的电脑通过局域网访问到这个服务

- OLLAMA_KEEP_ALIVE=60m, 这个是让模型能够在内存中维持60分钟,即便没有任何输入,从而避免重新载入内存的时间消耗

- OLLAMA_MODELS=E:\Ollama.ollama,存放模型文件的,如果C盘空间不足,就从用户目录移动一下

- OLLAMA_ORIGINS=*, 这个是允许跨源资源共享(CORS)所需要的,方便某些client调用ollama的api

完成ollama的安装和配置之后,就是使用CMD命令行,通过 ollama pull {model} 的命令下载模型, 例如:

ollama pull qwq大模型的本地化部署到这里就结束了。如果要快速尝试,可以在命令行中 ollama run 来尝试与大模型对话。不过实际使用时,我们会使用各种client来调用。

ubuntu服务器部署更新ollama

ollama更新很快,目前还得手动更新。首先是关闭正在运行的 ollama 服务。然后是通过curl命令联网更新ollama,再然后是修改配置文件,重新加载配置,重新启动ollama,具体命令如下:

sudo service ollama stop

curl -fsSL https://ollama.com/install.sh | sh

sudo nano /etc/systemd/system/ollama.service

sudo systemctl daemon-reload

sudo systemctl restart ollama配置文件内容备份一下:

该部分仅登录用户可见

此处评论已关闭