本文介绍一种新的机器人控制方法,可通过深度学习的方式从视频直接估计Jacobian场从而实现机器人的运动控制。

文章标题为《Controlling diverse robots by inferring Jacobian fields with deep networks》,2025年6月发表在Nature期刊上。

Mirroring the complex structures and diverse functions of natural organisms is a long-standing challenge in robotics. Modern fabrication techniques have greatly expanded the feasible hardware, but using these systems requires control software to translate the desired motions into actuator commands. Conventional robots can easily be modelled as rigid links connected by joints, but it remains an open challenge to model and control biologically inspired robots that are often soft or made of several materials, lack sensing capabilities and may change their material properties with use. Here, we introduce a method that uses deep neural networks to map a video stream of a robot to its visuomotor Jacobian field (the sensitivity of all 3D points to the robot’s actuators).

如摘要前半部分介绍,制作出高度仿生的机器人是该领域的一个长期的挑战。其中一个问题便是,传统的机器人的控制需要刚性结构连接并且还得精确建模,然而仿生机器人的材料通常包含多种软硬材料,然后又不太可能加各种传感器,这就给控制增加了很大的难度。所以这里就提出了使用深度神经网络从robot的运动视频估计所谓的 visuomotor Jacobian field. 最终实现robot的可靠控制。

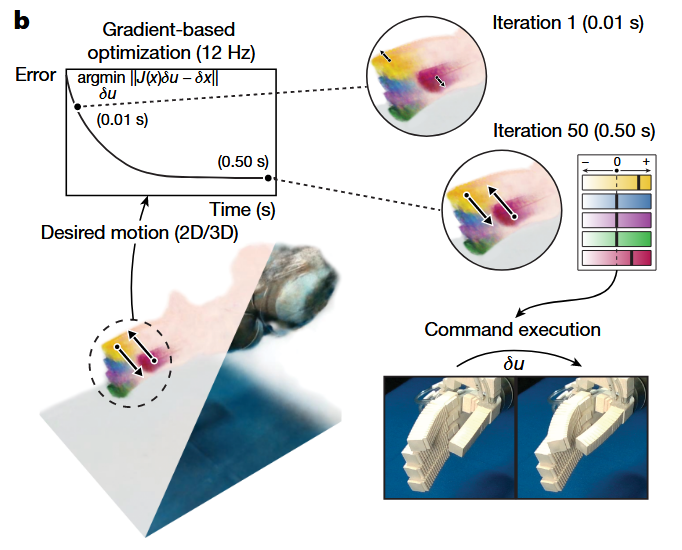

先看效果。如上图所示,根据一只机器手指的运动视频,在0.5秒内就能够实现迭代首先,产生最终优化的指令,控制食指和拇指产生正确的动作。

再补充下标题中出现的关键概念:Jacobian field,在机器人学中,指的是一个描述机器人末端执行器(end-effector) 或其周围三维空间中所有点对机器人关节(actuators) 运动敏感度的数学概念。

你可以把它想象成一个“敏感度地图”。在这个地图上,每一个三维点都对应着一个Jacobian矩阵。这个矩阵告诉我们,当机器人的某个关节移动一小段距离时,这个三维点会如何移动,以及移动的方向和速度。具体来说,Jacobian矩阵的每一列代表一个关节对所有三维点的影响,每一行则代表一个三维点对所有关节的敏感度。

通过对视频中机器人运动和其周围三维点变化的观察,深度神经网络会学习这些输入和Jacobian场之间的复杂非线性关系。它本质上是学习了一种“感知-作用”的映射:当机器人以某种方式移动时,深度学习模型会根据视觉输入预测出三维空间中的点会如何响应这种移动。这种映射的建立可能依赖于大量的训练数据,其中包含了机器人各种运动下的视频和对应的真实Jacobian场信息。神经网络通过不断学习这些数据,从而能够在新颖的视频输入下,准确地估计出Jacobian场。

简单来说,这种方法就是让一个聪明的“眼睛”(深度神经网络)通过看机器人怎么动,来理解机器人每个部位对周围空间点的影响。这样,我们就能在不知道机器人精确物理模型的情况下,通过视觉信息来推断出它“控制”三维空间的能力。

这种方法在机器人控制、人机协作、远程操作等领域都有潜在的应用,因为它允许机器人系统通过视觉感知来理解自身的运动能力,而无需复杂的传感器或预先编程的运动模型。

此处评论已关闭